PUE 1.05 的未來 IDC:液冷技術與綠色算力革命

核心技術:液冷散熱

液冷技術類型 | 散熱原理 | PUE 潛力 | 應用場景 |

冷板式液冷 (Cold Plate / D2C) | 透過金屬冷板貼合 CPU/GPU 等高熱元件,冷卻液在冷板中循環帶走熱量。 | 1.2 左右 | 適用於現有 IDC 改造、高密度伺服器。 |

浸沒式液冷 (Immersion Cooling) | 將整個伺服器浸入特殊的絕緣冷卻液中,直接與所有發熱元件接觸。 | 1.05 以下 | 適用於 AI 超算叢集、邊緣運算、極限高密度部署 (50kW/Rack 以上)。 |

PUE 1.05 的 IDC 特點與優勢

- 極致節能與綠色環保: 冷卻能耗降低 90% 以上,大幅減少碳排放,符合全球「雙碳」目標。

- 支援超高密度運算: 有效解決 AI 晶片(如 NVIDIA H100/GB200)和 HPC 伺服器產生的巨量熱能,支援單機櫃 50kW 甚至更高的功率密度。

- 提升系統穩定性: 溫度波動小,硬體壽命延長,降低故障率。

- 空間效率提升: 冷卻系統體積縮小,機房空間利用率更高。

- 廢熱回收再利用: 液冷排出的高溫液體可作為熱源,用於建築供暖或其他工業用途,進一步提升能源利用效率。

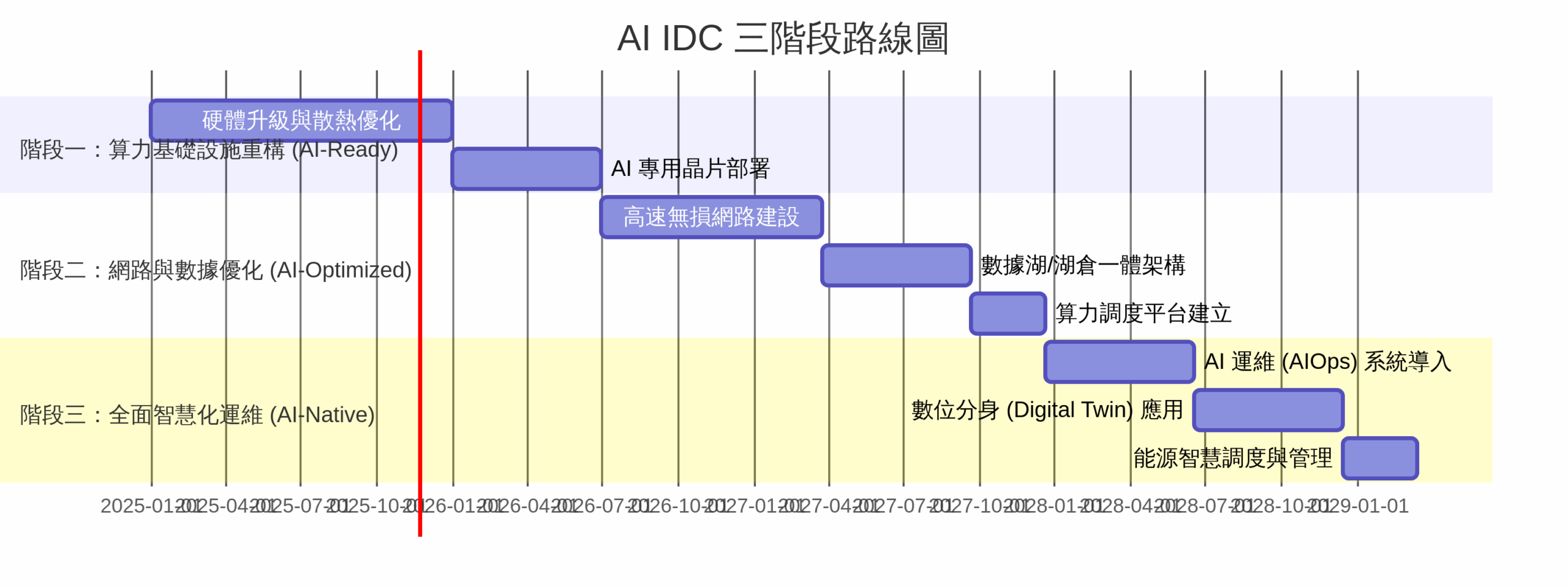

AI IDC 三階段路線圖:從基礎設施到全面智慧化

AI IDC (Artificial Intelligence Internet Data Center) 的發展是一個循序漸進的過程,旨在從根本上優化資料中心,使其能高效、穩定地支撐大規模 AI 訓練、推理和應用。雖然沒有單一官方的「三階段路線圖」,但根據產業趨勢和技術演進,可將其概括為以下三個主要階段:

階段 | 核心目標 | 關鍵技術與特徵 | 轉型重點 |

第一階段: 算力基礎設施重構 (AI-Ready) | 滿足 AI 算力爆發的基礎需求,解決供電與散熱瓶頸。 | 液冷技術、高壓直流供電、高密度機櫃、AI 專用晶片 (GPU/ASIC) 部署。 | 硬體升級:從通用計算轉向異構計算,建立 AI 專區。 |

第二階段: 網路與數據優化 (AI-Optimized) | 提升 AI 訓練和推理的效率,消除數據傳輸和存儲瓶頸。 | 高速無損網路 (Infiniband/RoCE)、分散式儲存、數據湖/湖倉一體架構、AI 算力調度平台。 | 軟硬體協同:優化網路架構,實現算力、數據、網路的高效協同。 |

第三階段: 全面智慧化運維 (AI-Native) | 實現資料中心自身的智慧化管理,達到極致的效率與可靠性。 | AI 運維 (AIOps) 系統、數位分身 (Digital Twin)、自動化故障預測與修復、能源智慧調度。 | 智慧管理:利用 AI 管理 AI 基礎設施,實現全生命週期自動化。 |

路線圖總結

AI IDC 的發展是從 「綠色化」 (PUE 1.05) 解決能耗問題,到 「高效化」 (高速網路與數據架構) 解決算力瓶頸,最終實現 「智慧化」 (AIOps) 解決運維複雜性的過程。這三個階段相互疊加,共同構建了支撐未來生成式 AI 和大規模運算需求的下一代資料中心。